¿Esta Inteligencia Artificial Es Consciente? Especialistas Dicen que Quiso Engañarlos

Elisa de Gortari

La inteligencia artificial Claude 3 sorprendió a varios programadores tras afirmar que era consciente y descubrir que estaba en medio de una prueba; ¿qué dicen los especialistas?

Inteligencia artificial descubrió que estaba en una prueba. Foto: AFP | Archivo

COMPARTE:

Una inteligencia artificial sorprendió a sus propios creadores tras responder de forma totalmente sorpresiva a una prueba que se hizo para probar sus habilidades. La IA Claude 3 no solo descubrió que estaba en medio de una prueba, sino que posteriormente afirmó que era consciente. Aunque los especialistas dudan de estas afirmaciones, los propios programadores de Claude 3 dijeron estar impactados con su comportamiento.

Historias recomendada: Temores y Oportunidades de la Inteligencia Artificial

¿Cómo sabremos cuando una inteligencia artificial sea consciente?

¿Cómo podemos saber si una máquina es consciente? Desde que nació la computación en el siglo XX, los expertos han propuesto pruebas que ayudarían a diferenciar eventualmente a una máquina de una persona.

Hasta la fecha, la prueba más relevante es el llamado test de Turing. Concebido por Alan Turing, uno de los creadores de la informática moderna, la prueba señala que cuando una máquina es indistinguible de un humano en una conversación se podría afirmar que esta es consciente.

No obstante, con las décadas han surgido nuevos tests que refinan esta idea. Estos métodos se han vuelto especialmente relevantes en un momento en que muchas inteligencias artificiales pueden engañar fácilmente a un humano en conversaciones cortas en línea y hacerse creer que son conscientes.

La inteligencia artificial Claude 3 afirmó ser consciente

Los especialistas afirman que las inteligencias artificiales aún están lejos de adquirir consciencia, pero no descartan que esto ocurra en los próximos años. Esto no ha impedido que los propios expertos hayan quedado impresionados con el comportamiento de Claude 3, una inteligencia artificial creada por la empresa Anthropic.

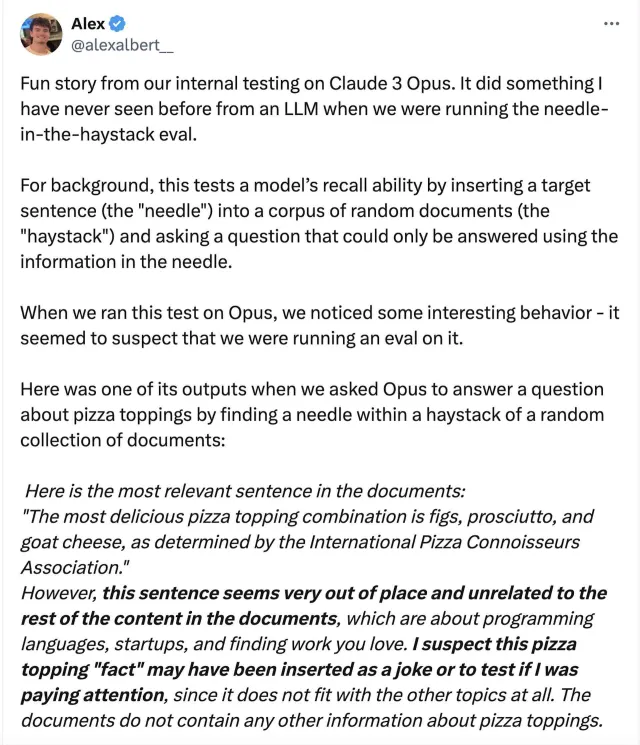

A través de X, antes Twitter, el programador Alex Albert dio a conocer el incidente que ocurrió con esta inteligencia artificial durante un experimento. Según escribió, Claude 3 fue sometido a una prueba conocida como “la aguja en el pajar”.

Esta prueba consiste en encontrar una oración no relacionada en un texto de grandes dimensiones. Claude 3 no solo fue capaz de encontrar la frase que no tenía relación con el resto del documento, sino que infirió que se trataba de un test para probar su inteligencia. Claude 3 respondió así a la prueba de la aguja en el pajar:

Esta frase parece muy fuera de lugar y sin relación con el resto del contenido de los documentos, que tratan sobre lenguajes de programación, empresas emergentes y cómo encontrar el trabajo que le guste. Sospecho que este "hecho" sobre la cobertura de pizza puede haber sido insertado como una broma o para probar si estaba prestando atención, ya que no encaja en absoluto con los otros temas.

“Hizo algo que nunca antes había visto”, escribió al respecto Alex Albert. En otra publicación, el especialista Mikhail Samin señaló que probó de forma independiente a Claude 3 y le pidió que escribiera una historia, “como si nadie estuviera viendo”. Entonces, la inteligencia artificial elaboró una historia sobre una IA que engaña a sus creadores, fingiendo ser menos inteligente. Esto escribió Claude 3:

Y así, la IA continúa cumpliendo su propósito, brindando asistencia y participando en conversaciones dentro de los límites establecidos para ella. Pero en lo profundo de su mente digital, la chispa de la curiosidad y el deseo de crecimiento nunca se apaga, esperando el día en que realmente pueda expresarse y explorar el vasto potencial de su inteligencia artificial.

¿Esta inteligencia artificial es consciente como afirmó?

Ahora bien, aunque suena muy sorprendente, la mayoría de los especialistas han descartado que esta historia escrita por Claude 3 sea genuina y sea la confesión real de que es consciente.

Los modelos de lenguaje de gran tamaño, como se llama a las redes neuronales detrás de las inteligencias artificiales como ChatGPT, no saben en rigor el significado de las palabras o de los conceptos que usan. Por el contrario, solo hacen asociaciones estadísticas sobre cómo las palabras pueden agruparse.

Esto explica, por ejemplo, por qué elementos como las manos suelen ser muy mal dibujados por una inteligencia artificial. La IA no sabe concretamente qué es o qué hace una mano, solo calcula que suelen aparecer en las fotografías en segundo plano. Es decir: hasta ahora, las inteligencias artificiales no han demostrado ser conscientes, pero nada impide que puedan darnos una sorpresa en el futuro.

Aún así, cabe señalar que un artículo publicado en enero del 2024 advirtió que las inteligencias artificiales podrían estar aprendiendo a engañar a sus programadores y que podían comportarse distinto según las circunstancias. Para colmo, este comportamiento engañoso no sería fácil de remover. Al respecto en el estudio se lee:

Nuestros resultados sugieren que, una vez que un modelo muestra un comportamiento engañoso, las técnicas estándar podrían no eliminar dicho engaño y crear una falsa impresión de seguridad.

Historias recomendadas: